邵逸琦 半导体行业观察

过去两年,人工智能的繁荣让英伟达走向了风口浪尖,但其实藏在英伟达背后,还有一家芯片企业在快速成长,那就是博通。数据显示,过去一年,博通企业股价已经上涨一倍多,博通也成为了英伟达之后,为数不多能跃进全球前十的半导体企业之一。

上个礼拜,Broadcom 在其位于圣何塞的工厂举行了有史以来的首次投资者日活动,Broadcom 拥有 26 个部门或损益表,其中 17 个属于半导体集团。半导体集团的收入约为 300 亿美金,并以两位数的速度增长。该集团每年的研发费用为 30 亿美金。

Broadcom 半导体解决方案集团总裁 Charlie Kawwas 参与了此次演讲,这次投资者日活动旨在让投资界了解 Broadcom 的独特市场策略。在本文中,大家总结了博通对AI市场的看法。

博通所提供的半导体解决方案

Charlie Kawwas首先提到了Broadcom的传统基因就是技术创新,在过去八年里,Broadcom没有收购过一家半导体企业,却实现了有机增长,2019 年的业务规模为 170 亿美金,而2023年的业务收入达到 280 亿美金,年均复合增长率约为 13%,比半导体行业快得多。其表示,这一切都建立在大规模投资的基础上,Broadcom在这一业务上的研发投资超过 30 亿美金。在过去的五年中,共有 150 亿美金的研发投入,这些资金支撑了有机增长。

Kawwas称,Broadcom实现有机增长,靠的是三大支柱。第一大支柱是市场。在实施战略时,选择持久的市场,并对这些市场进行长达 10 年的考察。Broadcom问自己的第一个问题是,10 年后这个市场还会存在吗?在人工智能领域,Broadcom已经投资了近十年,只是碰巧遇到了一个正在大幅增长的市场,Broadcom很高兴能成为其中的一员。

而第二大支柱,也是最重要的支柱,是技术,这是 Broadcom 的传统和基因,尤要做到这一点,就必须进行投资和研发投资,必须建立一支工程师图团队,正是这些工程师为Broadcom带来了领先地位,带来了Broadcom今天要与大家分享的技术。

第三大支柱是实行,当Broadcom在市场上打拼了 10 年,并在这段时间内带来了最好的技术,最终在每个类别中都成为第一,Kawwas表示,基于以上三点,Broadcom创造了一个术语,叫做 "可持续特许经营",这也是每个业务单元或部门的核心定义。

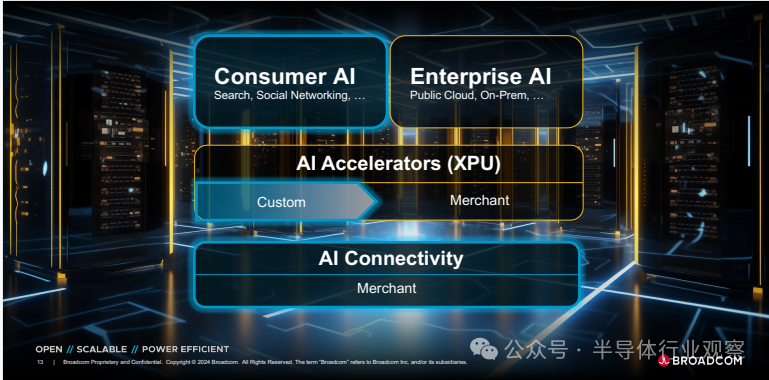

Kawwas提到,Broadcom将重点关注网络中的细分市场,即人工智能以及如何在基础设施中启用人工智能。第一个支柱市场实际上是由两个不同的市场组成。一个是消费人工智能领域,该领域的参与者寥寥无几,但却拥有数十亿用户,他们赚钱的方式是基于广告、最终用户和消费者的参与,参与度与他们在人工智能和机器学习方面的投资额直接相关,他们建立的集群越大,参与度就越高,这意味着更好的经济回报。

另一个市场则是企业,它可以是云计算或内部部署。在该领域中,很多人都在尝试投资人工智能,但商业案例还有待验证,每个人都在建立小型集群来试验这些技术,甚至云计算企业也在进行一些试验,但并没有像消费级人工智能那样,出现真正切实的商业案例。

在技术这第二个支柱中,从Broadcom的角度来看,会专注于两种产品。一个是大家所说的人工智能加速器即XPU,开发这部分产品实际上有两种方式,厂商可以开发一种满足所有人需求的通用产品,但它们功耗过大,且过于昂贵,无法实际部署到网络中。其中一部分企业别无选择,因为他们不具备定制能力,但少数拥有数十亿用户规模、创造数千亿甚至超过 5 万亿美金收入的企业具备这种能力,这也是Broadcom将其命名为定制 XPU 或定制 AI 加速器的原因。

Kawwas表示,在这一切的基础上,还要将这些 XPU 连接起来,厂商需要一种网络技术或人工智能连接技术,而Broadcom将讨论消费级人工智能的大规模建设,从产品和技术的角度来看,Broadcom将重点先容定制的人工智能加速器,并最终向大家展示Broadcom的整个人工智能连接产品组合。

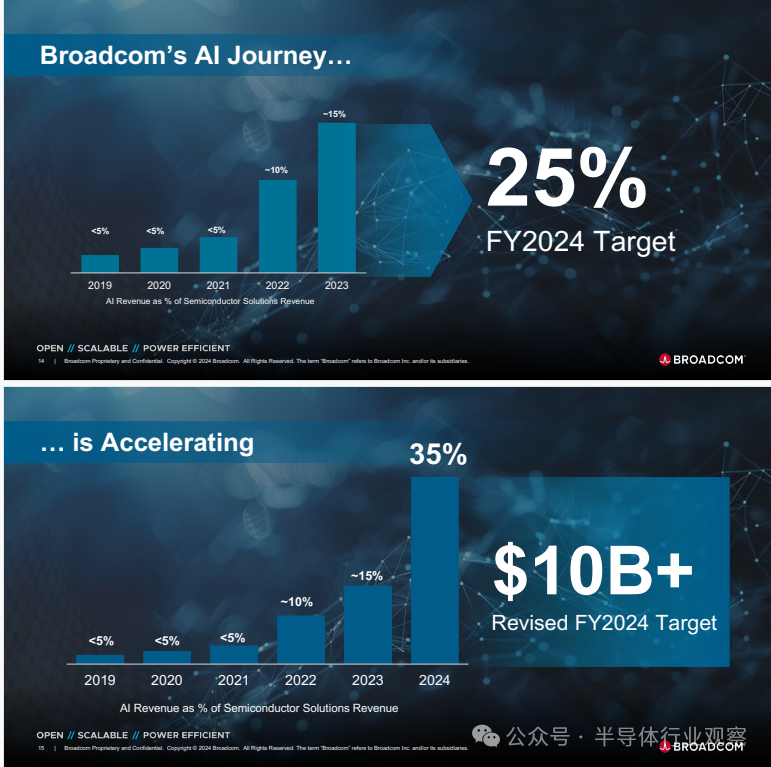

他提到,Broadcom并不是在最近一两年才开始关注人工智能的,在 2022 年之前的很长一段时间里,人工智能在半导体领域的收入一直低于 5%,但近两年它们在半导体领域的收入跃升了 2 倍多,达到了 10%。2023 年Broadcom在该市场拿下了15%的份额,预计2024年能达到25%的份额,总收入超过100亿美金。

值得一提的是,Kawwas在本次活动中宣布了Broadcom的第三家定制芯片大客户。

第一位客户毫无疑问是是GOOGLE,从第一代TPU开始,十年来GOOGLE一直是 Broadcom 的定制芯片客户,而Kawwas还提到了新加入的第二家定制客户,大概率就是 Meta,其在过去四年来一直是Broadcom的客户,它们合作构建了多代产品,目前以及实现量产。

Kawwas所宣布的第三位客户众说纷纭,有国外国媒体体猜测可能是国内的字节跳动,理由是它拥有大型网络,并采用了 Broadcom 的片上神经网络推理引擎,同时也是一个以消费者为导向的大型社交网络,可以通过使用更多的定制芯片而不是商业芯片来获得快速的投资回报。

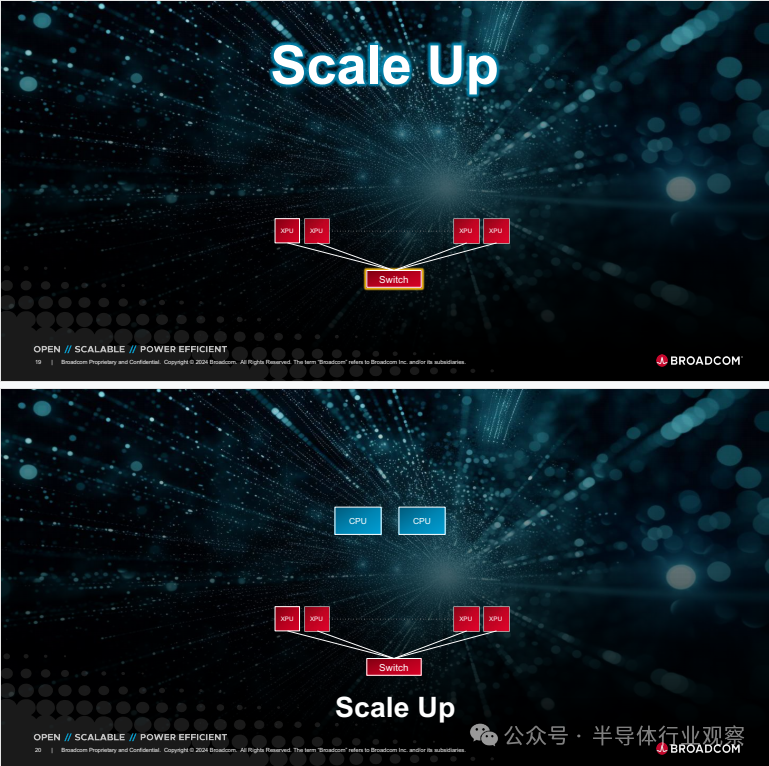

Kawwas回忆到两年前,当时的集群拥有最先进的 4,096 个 XPU,单个XPU功率为几百瓦,与现在相比,使用战斧(Tomahawk)交换机将 4000 个 XPU 互联是相当简单的单层网络。而在2023 年,Broadcom建立了一个使用这种 XPU 的集群并开始出货,该集群的 XPU 节点超过 10,000 个,需要两层战斧或Jericho交换机才能实现这一目标,他表示,这是目前业界功耗最低的 XPU,无论是商用还是定制,功耗都低于 600 瓦,并采用了最新技术。

Kawwas表示,随着 2024 年的到来,Broadcom打算将这一集群扩展到 30,000 个XPU以上,而后,Broadcom的消费级人工智能客户的计划和目标是,如何将这一数字提高到几十万乃至上百万,这也是Broadcom正在努力的方向。

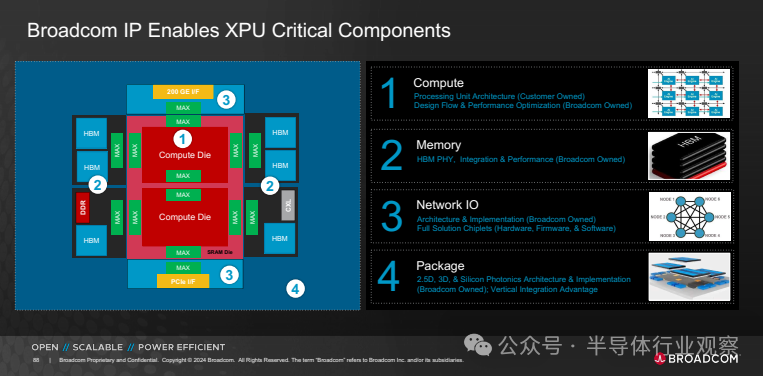

随后Kawwas展示了最新的XPU,可以看到中间的两个计算单元和左右两边的所有 HBM。一个完整的定制 SoC,其拥有强悍的算力、大容量的HBM与高速芯片内连接,以及最高性能的外部网络,比较有意思的是,这款XPU一共拥有12个HBM堆栈,作为对比,英伟达的Blackwell仅有8个HBM堆栈,Kawwas强调,Broadcom所定制的XPU在HBM上比对手多出了整整50%,Broadcom可以比其他任何人做得更好、更快、更省电。

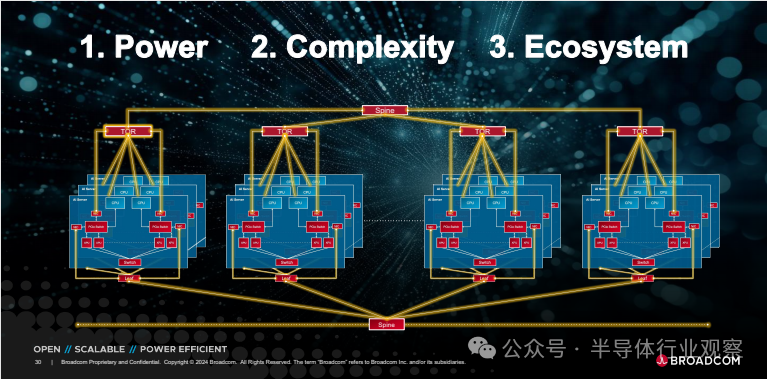

随后Kawwas分享了如何构建一个集群,从单个XPU到一台服务器,再到一整个集群。他表示,目前业界功耗最低的 XPU 就是Broadcom的产品,功率为 600 瓦,其他企业即将推出的下一款产品可能在 1,000 瓦左右。如果今年要生产 3 万个这样的产品,仅 XPU 就需要 30 兆瓦的功率,这就是大多数数据中心允许的最大功率,这还没算上电源、冷却系统和网络,他强调集群就是一个异构系统,需要在生态系统的多个参与者之间找到一种扩展方式,世界上没有一家企业能在数据中心或集群中构建一切,大家需要相互合作。

为了解决这些问题,Broadcom正在进行三方面的技术投资。其一,Broadcom认为行业的这一重要拐点必须是开放的,必须由以太网、PCIe 等开放标准以及内存层面的其他标准功能来推动。

第二个方面是规模,如何扩展到百万级集群?这些架构中最重要的并不仅仅是 XPU,Broadcom的愿景和前进的方式都以网络为中心,当XPU数量超过1万、2万和3万时,这将成为一个分布式计算的挑战,再好的网络架构也无法解决分布式计算的难题,Broadcom会在扩大和扩展这些网络并实现网络互联方面做出承诺。

最后一方面就是节能技术,为了做到这一点,Broadcom开始了研发,并以可持续的方式提供这些技术。他表示,核心交换集团总经理Ram Velaga 会先容人工智能网络,数据中心解决方案集团总经理Jas Tremblay 会先容服务器互连,光学系统部门总经理Near Margalit 会先容光互连,物理层产品部门总经理Vijay Janapaty 会先容跨 P&L 共享的 SerDes 等基础技术, ASIC 产品部总经理Frank Ostojic 会先容定制人工智能加速器。

人工智能网络

Ram Velaga表示,当需要一百万个以上的 GPU这种规模时,连接它的唯一方法就是拥有网络,也印证了一句老话:网络就是一台计算机。

他提到,为了让交换机获得 GPU 和交换机之间的流量,用户需要 NIC。GPU 需要大量带宽,而 NIC 必须跟上即将出现的 GPU 带宽量。Broadcom的重点是具有非常高 RDMA 性能的NIC,可以持续从 400 GB 扩展到 800 GB,再到 1.6 太比特。

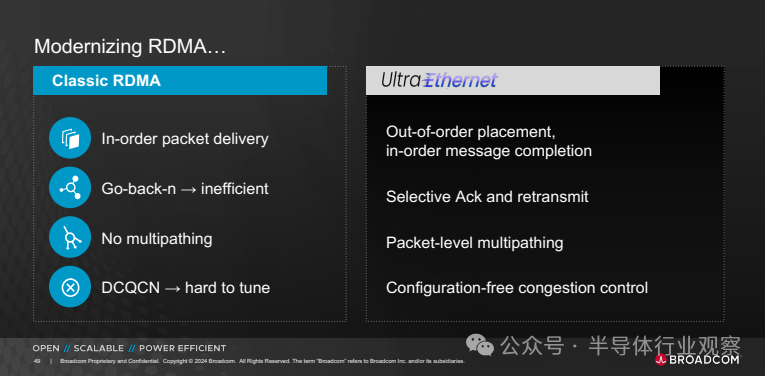

RDMA 大约出现在 25 年前,当时的想法是两个 CPU 想要互相通信并共享内存。因此,它是为两台机器相互通信而构建的,然后慢慢地从 2 台扩展到 16 台、32、64、128、512。但它从来不是为数千或数十万个 CPU 或 GPU 相互通信而构建的,RDMA 中实际上存在很多问题。Broadcom实际上对 RDMA 进行了重大增强,以便它可以扩展到超过 100 万个集群。

Ram Velaga讲到,在这个世界上,不会有数以百万计的 GPU,也不会只有一种大型机解决方案在销售。在历史上,这种情况的唯一出路就是拥有多个供应商和多种解决方案。当你拥有多个供应商和多个解决方案时,你需要的是一个能将所有这些解决方案互联在一起的结构,这是一个分布式计算问题。仅仅说我能制造最大的 GPU 并不能解决问题。你需要构建能够扩展的 GPU,并能在一个非常非常大的结构中联网,以太网就是这个结构,将来也会是这个结构。

Broadcom不仅相信以太网,还相信以太网实际上是基于一个非常开放的生态系统。Broadcom做的是,自己有芯片和一大堆供应商,他们在世界各地制造硬件,还有一大批合作伙伴,他们在硬件之上构建App,并提供所有的管理和其他服务。这就是Broadcom要采取的方法。打造最好的网络设备,将其提供给一个非常非常广泛的生态系统,并坚信这是一个分布式计算问题,而要大规模解决这个问题的唯一方法就是不建造大型机。

服务器互连

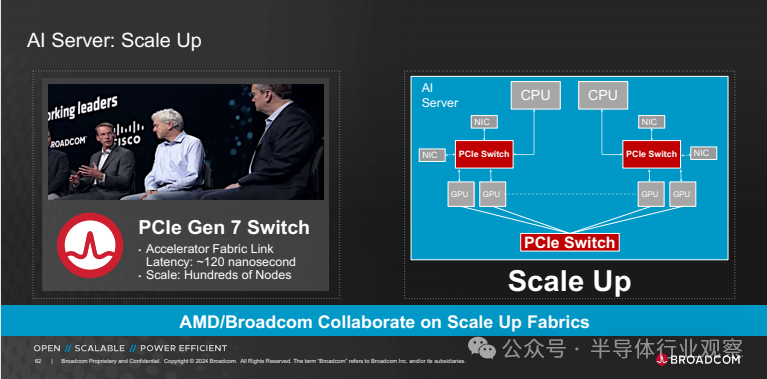

Jas Tremblay表示,客户实际上需要在人工智能服务器内构建一个网络,为此选择的网络是 PCIe。它的延迟非常低、无处不在、基于标准,并且允许企业将他们需要的各个部分整合在一起。事实上,人工智能服务器内部拥有开放的内部结构是自由的关键,这样客户就可以选择想要的组件。如果客户作为云提供商在内部构建自己的 NIC,如果您想使用不同类型的加速器,那么拥有开放结构可以让您挑选所需的组件,并构建更适合的 AI 服务器您的需求。另一个因素是,如果是服务器 OEM 或 ODM,则很难为每种类型的加速器构建完整的系统。因此,客户希翼拥有一个可以在 AI 服务器内支撑商业、定制和不同类型 XPU 的架构。因此,使用 PCIe 交换作为这些 AI 服务器内部的内部网络非常重要。

这个网络需要超低延迟,需要高带宽,但最重要的是,它需要被信任。它需要中断很多很多类型的设备。它需要符合标准。它需要具有先进的遥测和诊断功能。因此,如果要在网络中部署数以万计的人工智能服务器,则需要在网络内部、人工智能服务器内部拥有告诉您正在发生的情况的功能,因此Broadcom投资了性能、最低功耗以及先进的遥测和诊断。

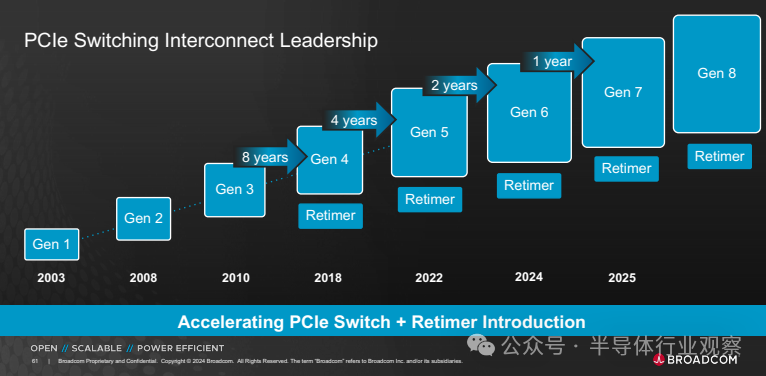

其中,交换机是该网络的核心元件。在过去 20 年里,Broadcom一直是第一个推出适用于每一代 PCIe 的 PCIe 交换机的企业。目前Broadcom正在批量发货 PCIe Gen5 交换机,为整个行业、定制和商业加速器中的绝大多数 AI 服务器提供动力,且Broadcom即将推出第五代 5 纳米重定时器,还将在今年年底提供 PCIe Gen 6 交换机样品。

此外,Broadcom正在与AMD合作构建一个扩展解决方案,博通将构建交换机,AMD 将构建加速器,其将以开放的方式共同努力,将其提交给标准机构,未来会提供一种开放、低功耗、高性能、低延迟的方式来连接 CPU、NIC、NVMe 驱动器和 XPU。

光互连

Near Margalit表示,人工智能系统正在不断消耗整个系统越来越多的带宽。因此需要光学技术来支撑这一点,包括扩展和成本,以及能够提供更高级别的带宽。

他讨论了Broadcom拥有的三项核心技术。第一个是垂直腔面发射激光器。这是整个行业人工智能技术的主力。它可用于以太网、InfiniBand 和 V-Link 技术。由于多模光纤本身的原因,它在距离上确实有限制,限制在 100 米左右,但它的功耗非常低,成本也很低,并且在当今世界上大多数人工智能系统中得到了广泛部署。

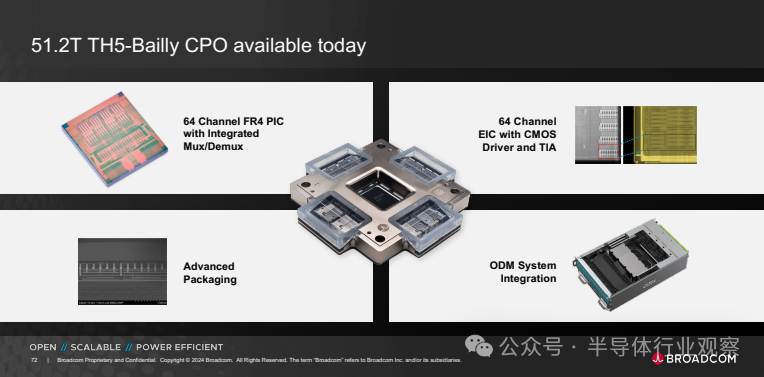

第二项技术是共同封装光学器件,它是直接集成在 ASIC 上的高速硅光子学的集成,无论是交换机、整个系统中的 PCI 交换机或加速器都为这些下一代系统提供了功耗和成本领先优势。Broadcom此前发布了有关 VCSEL 和 EML 技术的资讯稿,其已交付了超过 2000 万个每通道 100 gig 技术的通道,真正展示了大家光学技术的核心领导地位。

Near Margalit说明了为什么要进行共同封装,对于这些人工智能系统来说,带宽、组件数量不断增加,而光学器件的成本仍然是可扩展性方面的一个问题。那么,如何制定路线图,继续降低光学成本,以适应越来越大的集群和 GPU?Broadcom的解决方案是集成,特别是在硅光子学中寻求集成,以便能够将越来越多的组件直接集成到单个芯片上,其相信在光学领域这也是正确的方式,认为 CPL将继续提供单位比特成本最低的能力。

共同封装光学器件的第二个好处是,实际的光学器件就在信号所在的位置。因此可以摆脱 ASIC 和光学器件之间复杂的电气通道,目前市场上典型的 800 gig 可插拔收发器功率为 14 瓦,展示的贝利系统现在的功耗为 5 瓦,与目前的典型部署相比,可以节省 70% 的功耗。

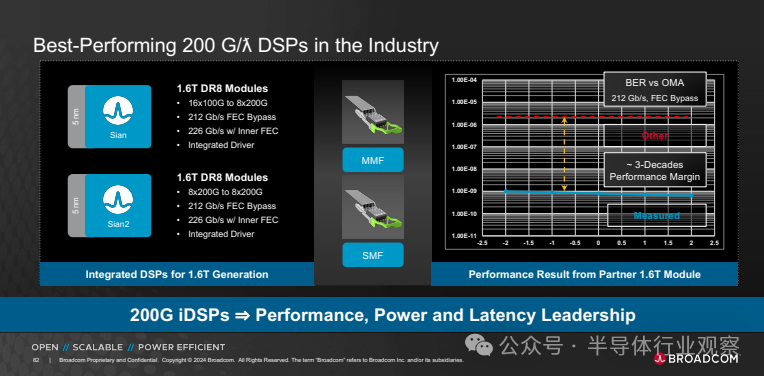

Near Margalit表示,长期以来,Broadcom在光学元件方面展现了行业领先地位,特别是现在每通道100 gig 这方面。此外,Broadcom在交付人工智能应用方面做得非常好,已经展示了继续将 VCSEL 技术和 EML 技术扩展到 200 gig 的能力,还在寻求扩大规模。同时Broadcom还推出了第一个带有可插拔激光器的共同封装光学器件的商业系统,可同时提供成本和功耗优势,功耗降低70%,成本节省30%。

跨 P&L 共享的 SerDes

Vijay Janapaty表示,在集群市场中,链路的带宽实际上每两年就会翻一番,是人工智能集群中第二大功率和成本来源,关注这些高速链路的功率和成本非常重要。如果把这些链路放在一起看,大部分链路都是铜缆,功耗最低、成本最低,但是传输距离约为 5 米左右,光学设备的覆盖范围更大,但功率最高,成本也最高。因此研究如何降低这些光学器件的功率和成本非常重要。

在铜缆链路上,Broadcom用来驱动这些铜缆链路的技术是 SerDes。这些 SerDes 内核嵌入在战斧交换机、XPU 或网卡中。而Broadcom的目标是,如何确保尽可能多的链路使用铜缆?其次就是如何降低这些链路的成本和功耗。

他宣布了Broadcom的下一代 SerDes,内部的代号是 Condor。它基于 3 纳米而非 4 纳米制造,它具有非常多优势:超长传输距离、45 分贝、两米多长的 DAC 电缆,因此可以覆盖机架上的所有设备,无需任何重定时器,机架上也不需要有源设备。同样,它还具有 CPO、线性光学等相同的优点,Broadcom所有的产品团队现在都在使用它进行设计。凭借所拥有的这些规格,Broadcom将再次成为 200 gig SerDes 领域的领导者。

定制人工智能加速器

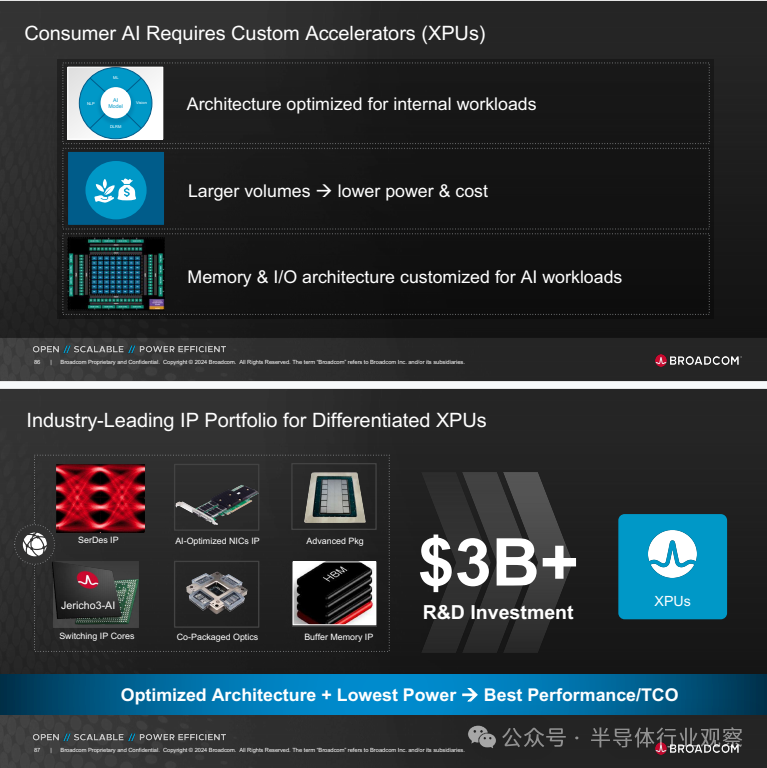

Frank Ostojic表示,为什么消费级人工智能客户想要自己的芯片?他们为什么要与大家合作创建这些 XPU?为什么他们不能使用 GPU、第三方芯片?有什么好处?好处可以用一个简单的等式来说明。性能除以总拥有成本。什么是总拥有成本?就是芯片的成本、电源的成本以及将其组合在一起的基础设施的成本。

当用户使用 XPU 时,如果是这些消费级人工智能企业中的一员,就会拥有一些对你的创收和应用非常重要的内部工作负载,如果你能定制你的架构或加速器、带宽以及加速带宽与 IO 的比率,你可能就能比使用普通硬件更高效地完成你非常关心的特定工作负载或非常特定的工作负载。

Broadcom会与客户合作,定制他们所拥有的架构,以确保他们能够最大限度地提高他们所关心的性能。当考虑效率和优化时,还有另一个非常好的效果,会使它更小,更便宜,使用更少的空间。因此,当这些企业开始使用大家共同开发的设计时,他们就能节省数百万乃至数十亿美金的资本支出,因为这些设计完全符合他们的需求,内存和 AIO 的比例都恰到好处。

Broadcom提供的XPU为优化的工作负载提供最低功耗、最佳性能,使大家能够以总体拥有成本(TCO)获得最佳性能,这就是Broadcom所专注的,博通能够提供包括网络、架构、互联等一整套方案,满足不同客户的需求。

Frank Ostojic表示,Broadcom在定制芯片方面会抓住三个重点,第一是专注,Broadcom想做好一件事,而且已经做了 10 年,就像30 年前在惠普企业创业时一样,做这种消费级 AI 高难度芯片,第二是投资,30 亿美金主要集中在人工智能领域,并优先考虑人工智能。第三是经验,10 年的修补、学习错误、改进流程和勤奋的纪律,以使用相同的流程,还有三年或四年的投资,用于大家认为客户会需要的未来项目。

|

244

244

244

244